在之前的”Web Spam Detection“与”Link farm detection”谈到搜寻引擎可以判断垃圾网站的成份,但是许多意图操作的人还是会想出方法,想要逃脱搜寻引擎的侦测,我们来看看常见的例子与其破绽…

有些人会认为,既然link farm (链接农场) 有以下的链接特性(如下图),因此就会思考做出不一样的链接状态。

(资料来源: A New Enhanced Technique for Link Farm Detection)

例如刻意在许多页面,链接到无辜的第三者网站或是政府网站。

其实这样的作法还是没有办法躲避侦测,因为链接农场可以自己操作连外的链接,但是没有办法「自然的」操作连进来的链接。

顶多可以购买少数的高Pagerank的网站来抬高身价,但是要达成多样性且高品质的话,所花的代价根本不敷成本。

并且故意链接到无辜的第三者网站,更容易因为第三者网站的外部链接报告(如Google网站管理工具),而自曝身份。所以要把人为链接操作到自然并且有效,除非投入大量的人力与财力,否则是不可能有效的。就算短期有效果,随着搜寻引擎的演算法改善,更可能一夕完全失效。

除了透过link schemes之外,还可以透过内容与链接的相关性来了解link farm。也就是在”链接不是原罪,Google也不是大神”说过的,链接最基本的规范= 客户必须知情or 内容必须相关。如果在网页内容插入不相关的链接,并且没有NoFollow,如果不相关链接类型的数目越多,则就越可能是link farm。

网站是否为link farm (链接农场), 其实只需要看整体链接状态,以及整体不相关非NoFollow的链接数目,就可以知道。

但是相关性如何判断呢? 之前曾经在”搜寻引擎知道网页内容是否相关(relevant content)?”提过,我们再来仔细的看看。

最经常被用来判断文件相关性的方法,有TF-IDF、Euclidean Distance、Cosine Similarity、Jaccard Coef?cient、Pearson Correlation Coef?cient … 等等。

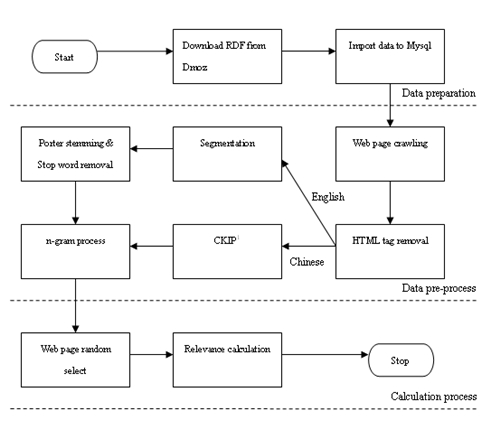

为了正确的了解这些演算法是否可以自动判读文件相关性,我们以下列的流程来进行实验,并且检定出有显著改善的演算法 :

上面的步骤分成三大程序:

第一步是由已经人工分类的DMOZ中倒出所有的资料,汇入MySQL中,以备后面程式使用。

第二步是资料的预处理步骤,先进行网页资料抓取,然后取出我们需要的资料,分成英文与中文分别处理字词的分析,让抓取的资料还原到基本的单词。

第三步就是把第二步处理过的资料,进行演算法计算与比较。由此便可以知道各演算法计算出的相关性数值,并且比较各种不同演算法的精准度。

结果发现所有的演算法在所有的资料实验中,其精准度都达80%以上,并且某些演算法其精准度还达90%以上。

这个代表的是: 使用最简单的方法、以最便宜的程序,就可以快速轻易的知道网页间的相关性。所以Google等搜寻引擎会不知道吗? 当然会比我们更清楚。